机构名称:

¥ 1.0

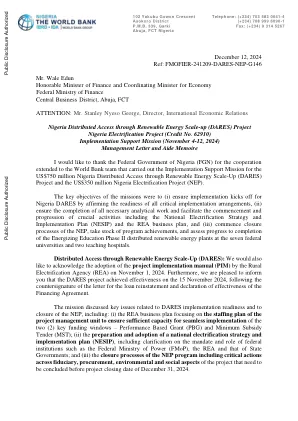

随着深度神经网络的最新突破,自动驾驶中的NU务任务表现出了很高的表现。但是,深度学习模型容易受到对抗性攻击的影响,对自主驾驶系统呈现了重大的选择风险。目前,由于其在不同任务上的协作性质,最终的结构已成为自主驾驶的主要驾驶。然而,对此类模型的广告态攻击的含义仍然相对尚未探索。在本文中,我们首次对模块化自动驾驶模型进行了全面的对抗性研究。我们彻底考虑了模型推理过程中的潜在漏洞,并通过模块噪声注入设计通用攻击方案。我们在全栈自动驾驶模型上进行大规模实验,并证明我们的攻击方法表现优于先前的攻击方法。我们相信我们的研究将为确保自动驾驶系统的安全性和可靠性提供新的见解。

arxiv:2409.07706v1 [cs.lg] 12月12日2024

![arxiv:2409.07706v1 [cs.lg] 12月12日2024PDF文件第1页](/bimg/4/404c26b122f665ffcfd392c97c9c5b4fe06fb71d.webp)

![arxiv:2409.07706v1 [cs.lg] 12月12日2024PDF文件第2页](/bimg/5/512aec325591866ded5202c619ed7f10a5ebdd10.webp)

![arxiv:2409.07706v1 [cs.lg] 12月12日2024PDF文件第3页](/bimg/8/8f830af14f9a881e2207faf75afd8c7e54eedea1.webp)

![arxiv:2409.07706v1 [cs.lg] 12月12日2024PDF文件第4页](/bimg/f/f5d1e86fd07909370592ec755670a55b5caf8069.webp)

![arxiv:2409.07706v1 [cs.lg] 12月12日2024](/simg/2/2075ffb35ed77cb5869bbdbde29801a66635d8b1.webp)

![arxiv:2401.01757v4 [Math.pr] 12月12日2024](/simg/7/73756ba68cb9cdad0fa644bb2d27f2ed5e110168.webp)

![arxiv:2409.16636v1 [cs.cl] 25 Sep 2024](/simg/b/b129a6cc9ff56599077700126545c20fcdc020f0.webp)

![arxiv:2409.09972v1 [cs.ro] 16 Sep 2024](/simg/f/ff362a65c62a58b59167bf67a65f0972591c084a.webp)

![arxiv:2409.14633v1 [cs.ro] 23 Sep 2024](/simg/7/7bf81d78b5e22cfcb825fad153a724111581e93c.webp)

![T.E. SEM。 vi @ vidyalan [12月。 2024]

每2020](/simg/1/1ef6f05f958bafb49dcc1ccc00a0939b8367fcbe.webp)

![arXiv:2409.02509v1 [quant-ph] 2024 年 9 月 4 日](/simg/9/9e13219e1d5a20db0a7166df4e72db959a994113.webp)

![arXiv:2409.05938v1 [q-bio.QM] 2024 年 9 月 9 日](/simg/0/0272ccc6b52372b7fb02c15d656e0c8c379710cb.png)

![arxiv:2409.10380v2 [cond-mat.mes-hall] 24年9月24日2024](/simg/6/669cc5e60579e0516e6a48d7c6b8bce3cd3d77e4.webp)

![arxiv:2410.19363v2 [cs.cv] 2024年12月23日](/simg/6/686e38225a84bacafbcd016080a298d9958cd5fd.webp)

![arxiv:2401.06521v1 [cs.cv] 2024年1月12日](/simg/a/ac4e8a79e62bb77bebd81435441586ea29fdf974.webp)

![arxiv:2412.05024v1 [cs.ro] 2024年12月6日](/simg/8/87d4fa5715751706d180dd1f0a48fb98bfa72b7d.webp)

![arxiv:2501.06907v1 [cs.lg] 2025年1月12日](/simg/5/584bd367ef6a329bbc6fec1335a5fa5c13bb982d.webp)

![arxiv:2412.14135v1 [cs.ai] 2024年12月18日](/simg/b/ba6858cc5362071828a21c1cb0683c3c2b12b707.webp)

![arxiv:2402.18703v2 [Quant-ph] 2 Jul 2024](/simg/6/629bf2f9c7927c2d96ab300dabb1043c2bb73845.webp)

![arxiv:2412.08580v2 [cs.cv] 2024年12月13日](/simg/1/19dd6a46813f915b66aeefb39547498261a82650.webp)

![arXiv:2409.09627v2 [cs.HC] 2024 年 9 月 19 日](/simg/c/c8e3f7a5d0004df336e46e4f53c7b5077e828ac6.webp)

![arxiv:2009.05741v1 [Math.oc] 2020年9月12日](/simg/b/bb1043a74b22730808ba5d30f6a2618da6f71fcf.webp)

![arxiv:2012.15294v1 [eess.iv] 2020年12月30日](/simg/4/440d22a9e2e4d8344dbfe06477ccfb76b9f91828.webp)